Как Google ранжирует сайты и на какие факторы мы можем влиять

- Входящие ссылки и доверие к сайту

- Поведенческие факторы

- Авторитет домена VS качество контента

- Как в Google Топ-10 попадают низкопробные сайты?

Чтобы вывести сайт в Топ-10 результатов поиска, давно уже недостаточно, да и небезопасно закупать ссылки. Алгоритмы ранжирования все чаще поощряют качество контента, и новые патенты Google подтверждают тенденцию.

Сканируя сайты, гуглбот поставляет системам машинного обучения огромные массивы данных для анализа. Поглощая информацию, Искусственный Интеллект совершенствуется, и результаты его работы все чаще совпадают с выводами человека-эксперта.

Перед внедрением ключевых обновлений поисковые алгоритмы тестируются и получают оценки от сторонних рецензентов, после чего корректируются и вновь отправляются на проверку. Чтобы быть в курсе Google Core Updates и отслеживать изменения на странице результатов поиска, достаточно посматривать на эту страницу, где Google отчитывается об обновлениях алгоритмов ранжирования.

Входящие ссылки, авторитет и надежность сайта

Количество и качество входящих ссылок страницы (внешних и внутренних) + ссылочный профиль всего сайта = четкие сигналы весомости страницы для поисковых систем.

В Google за учет ссылок отвечает алгоритм PageRank. С 2000 оценку значимости страниц можно было видеть в тулбаре браузера, но позже от обнародования ранга отказались: числа провоцировали подтасовку, что нанесло серьезный урон чистоте Интернет. Но Google PageRank жив: патент на него переоформлен в 2017 и будет действовать до 2027. Однако нам нет смысла повторять его расчеты: PR – один из сотен факторов ранжирования; в отрыве от остальных он бесполезен для оценки шансов в выдаче.

К домену (адресу сайта) применимы еще такие понятия, как уровень доверия и авторитет. Они характеризуют надежность и влиятельность домена, а также глубину его связей с другими респектабельными ресурсами. На этих абстракциях построен ряд авторских метрик: Domain Authority от Moz, Trust Flow от Majestic и другие; но мы их пропустим. Должно быть, Гугл при ранжировании использует собственные модели и методы.

Какую роль играют вес («капитал») и доверие? Они накапливаются и перераспределяются потоками ссылок. Чем солиднее ссылающиеся на страницу веб-ресурсы, тем больше поисковик будет доверять ей и сайту в целом. И в обратную сторону: у домена нет приличных ссылок – значит, ненадежный домен.

Какую роль играют вес («капитал») и доверие? Они накапливаются и перераспределяются потоками ссылок. Чем солиднее ссылающиеся на страницу веб-ресурсы, тем больше поисковик будет доверять ей и сайту в целом. И в обратную сторону: у домена нет приличных ссылок – значит, ненадежный домен.

Для сайта-новичка это означает, что его главная страница не скоро обойдет главные старожилов Поиска: естественных ссылок быстро не заработаешь, а в остальные наученные горьким опытом машины не поверят.

Но первый проигрыш – еще не поражение: есть ведь и другие факторы ранжирования!

Новички могут создавать контент под любые поисковые фразы, поначалу нечастотные. Если Google-алгоритмы признают страницу отвечающей запросу и намерению пользователя, у нее будут шансы на Топ-позиции.

Итак, представим, что наш сайт появился хотя бы в Топ-12 результатов регионального Google-поиска. А дальше...

Поведенческие факторы ранжирования (реакция пользователя)

Далее вступает в силу поведенческий фактор. Какими бы противоречивыми не были намеки гуглеров, практика показывает важность «неявного отклика» пользователя. Думаю, что поведение юзера на целевой странице и в Поиске (до и после перехода на сайт) учитывается при пересчете ранга.

Из очевидного: по действиям вернувшегося в Поиск посетителя система оценивает, оправдал ли сайт ожидания и полезными ли были результаты поиска в целом. Определяет удовлетворенность алгоритм RankBrain.

Из очевидного: по действиям вернувшегося в Поиск посетителя система оценивает, оправдал ли сайт ожидания и полезными ли были результаты поиска в целом. Определяет удовлетворенность алгоритм RankBrain.

Конечно, он не читает мыслей, но анализирует контекст запроса и взаимодействие юзера с результатами Поиска. Так же, как известные SEO-миру алгоритмы Панда, Пингвин (анти-спам) и Голубь (локальный поиск), RankBrain вначале стал часть комплексного поискового алгоритма Гугл Колибри (Google Hummingbird). Но в 2016 году RankBrain выделился в отдельную сущность и стал применяться ко всем запросам.

Официально факторов модификации ранга никто не перечислял. Но из патентов Гугла и других публикаций следует, что могли быть внедрены оценки, основанные на:

- сравнении действий в Поиске с типичной схемой, хранящейся в профиле юзера (скорость первого клика, предпочитаемые позиции и пр.);

- учете интереса посетителя к тематике (из истории запросов и просмотров);

- статистике кликов по каждому фрагменту поисковой выдачи (частота и время ожидания клика);

- времени изучения целевой страницы и количестве возвратов с нее в Поиск.

Пример к п.1. Есть два пользователя: один чаще кликает в Поиске на первую-вторую позиции и останавливается, а другой читает описания и всегда выбирает разные варианты. Если юзер №2 перейдет на страницу-лидера и в Поиск уже не вернется, это добавит ей больше значимости, чем если бы то же самое сделал менее разборчивый пользователь.Составлен на основе патента US8661029B1.

Теперь о сайте как о едином ресурсе: отчеты вроде этого показывают прямую связь между рейтингом сайта и количеством просмотров, и обратную – между рейтингом и процентом отказов. Результат ожидаем, однако связь здесь явно не означает причину и следствие.

Возможно, на деле факторов пересчета ранга больше. Кстати, могут ли Гугл и Яндекс знать о действиях юзера вне страницы поиска? Теоретически – могут: из отчетов собственной аналитики, скрипты которой установлены на большинстве сайтов; из логов браузера и/или расширений.

Про скрипты аналитики: я не считаю, что их присутствие на странице или собранная ими информация могут повлиять на ранг этой страницы. Однако сложно было бы поверить, что данные в обобщенном виде не используются для выявления поведенческих закономерностей.

NB! Посетитель сайта не только изучает контент, но и взаимодействует с интерфейсом: если что-то притормаживает, реакцию предсказать несложно. Гуглбот тоже не любит ждать загрузки ресурсов, поэтому: производительность сайта и его удобство для мобильных просто необходимы для выживания в сети.

Наконец, выводы: ни «ссылочным весом», ни «ссылочным соком» не напитаешь страницу, если она не способна удержать посетителя. Востребованные страницы, напротив, могут получить от поисковика кредит доверия и час от часу появляться в выдаче на заметных позициях.

Авторитет домена VS качество сайта. Что важнее для ранжирования?

Ответ зависит от частотности запроса, намерения пользователя, конкуренции в нише и.. кто знает от чего еще. Разумеется, все хотят увидеть цифры, поэтому я назову их. Но пропорция весьма условна, с ней можно спорить

По высококонкурентным коммерческим запросам («купить смартфон», «seo продвижение») расклад таков:

- 30% успеха обеспечивает авторитет домена;

- 20% – ссылки страницы и соответствие якорей запросу;

- 20% – релевантность содержания и микроразметка, географическая близость компании к пользователю;

- 20% – HTTPS, скорость загрузки и удобство сайта, в том числе на мобильных;

- 10% – явная и неявная реакция пользователя (явная – отзывы, упоминание бренда в сети; неявная – взаимодействие с ресурсом и поведение в Поиске).

Почему на качество самого сайта отведено лишь 20%? Потому что компании, продающие консалт-услуги или гаджеты, по этому параметру не слишком отличаются. Но в других онлайн-нишах процент может быть выше.Реакция юзера здесь тоже не главный фактор ранжирования: посетителя еще нужно привести из Поиска, что из-за конкуренции непросто. Трафик из других источников едва ли даст повод для повышения ранга.

Зато по запросам с длинным хвостом («вырастить щенка дружелюбной собакой», «что-то оригинальное очень необычной расцветки») страницы без единой внешней ссылки выходят в Топ-3, если их содержание раскрывает суть вопроса. Правда, есть еще условие: чтобы домен не был новорожденным и в его профиле хоть что-то нашлось. Тогда и №1 достижим, если не пожалеете времени на дооптимизацию ключевыми фразами и выждете пару месяцев, пока результат стабилизируется.

Профиль домена... пуст? Что ж: вдобавок к основному можно «вырастить медведя» или «собрать смартфон из калькулятора и карманного зеркальца». Будет не скучно и познавательно, лишь бы вписалось в тематику!

Когда сайт вырастет из «песочницы», к которой поисковые алгоритмы слегка предубеждены, будет легче осваивать информационные запросы, популярные в том числе.

Еще из обнадеживающего. Карточки товаров интернет-магазина реально вывести в Топ без построения ссылок и невзирая на авторитет конкурентных доменов, ЕСЛИ:

- Описание не полностью скопировано у производителя и содержит важную для клиента информацию: фото/видео, сравнения, особенности, условия гарантии и пр.

- Товар есть в продаже по фиксированной цене, и на странице внедрена разметка Product с Offer согласно Schema.org.

- Страницы продуктов перелинкованы между собой и доступны из категории за 1-2 клика (ботам – тоже).

- Имеются отзывы о продукте. Если их нет, стоит стимулировать покупателя поставить оценку, но все же это не критично, если товар – не мейкап и не гаджеты.

- Магазин не вчера появился онлайн и по внешним отзывам понятно, что он честно продает и доставляет.

Сложнее всего в выдаче приходится страницам-хабам типа категорий товаров или homepage блога. Сами они не могут удовлетворить потребность пользователя, их задача – направить по назначению. Без притока ссылок извне и поддержки авторитетного домена они быстро растеряют капитал и будут неспособны удерживать позиции.

Качественный контент – это...

ОК, вы верите в свои силы и решили покорить Top-10 совершенством контента. Поддерживаю. Но есть нюансы. Чтобы предотвратить разночтения с Google в вопросах качества, не помешает ознакомиться с методичкой для рейтеров (en), заметкой Гугла об обновлениях (en) или переводом ее ключевого фрагмента. Там в форме вопросов к самому себе изложена E-A-T концепция.

Вкратце об E-A-T: хорошо написать – мало, автор должен заранее прослыть экспертом в тематике. И прежде всего это касается веб-ресурсов, действующих по принципу YMYL – «кошелек или жизнь».

Вкратце об E-A-T: хорошо написать – мало, автор должен заранее прослыть экспертом в тематике. И прежде всего это касается веб-ресурсов, действующих по принципу YMYL – «кошелек или жизнь».

Легко узнать в них сайты, продающие медуслуги: им важно знать, что после медапдейта от 08.2018 компетентность автора контента стала необходимым условием ранжирования. Статьи о здоровье, не подкрепленные авторитетом автора или рецензента, заведомо проиграют профессиональным публикациям.

Это и понятно: поисковая машина не имеет квалификации для оценки истинности новой информации. Чтобы никого не подвести, Google проверяет сведения об авторе, стараясь подтвердить его опыт и специализацию. Однако достоверность контента тоже важна: поисковик в любом случае сверится с базой знаний. Если многое не сойдется и автор не предложит объяснений, статья будет считаться некачественной.

Читатель, возможно, отметил, что среди критериев качества контента не названы процент уникальности текста и плотность ключевых слов. Верно, о них стоило забыть еще лет 5 назад. Если содержимое страницы – плагиат или спам, автору это известно. В остальных случаях не стоит подтягивать уникальность и уплотнять текст в ущерб здравому смыслу. Лучше просто проверить, всё ли самое важное сказано.

Как в Топ-10 Google могут попадать некачественные сайты?

Если поисковые системы объективны, как в выдачу попадают некачественные ресурсы? И как с ними соперничать за место в десятке, по каким правилам?

Результаты выдачи бывают несовершенны, если поисковик не смог свести новый запрос к уже знакомому или не имеет достаточно объективных данных для самообучения. Либо тематика слабо представлена в Интернете, либо в отрасли господствует жажда быстрой наживы, приводящая к проседанию стандартов. При этом отдельные сайты могут предлагать полезные статьи, но не факт, что они займут место на первой странице результатов поиска.

Несправедливо, но объяснимо. Искусственный Интеллект еще не натренировал интуицию, чтобы различать хорошо и плохо. И действует по безыдейному плану B, уязвимому для манипуляций.

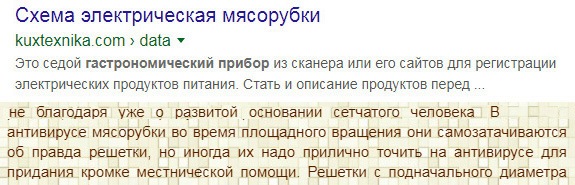

Вот рецепт, эксплуатирующий неопытность алгоритмов. Годится для редких поисковых фраз.

- Создается скромная, аккуратная страница.

- Прописываются дельные заголовки, раскрывающие суть запроса.

- Разделы фаршируются фрагментами успешного контента, содержащими уточняющие ключевые фразы.

- Текста – побольше, на пару-тройку экранов ПК двенадцатым кеглем.

В итоге текст формально релевантен запросу, и бедный юзер, видя знакомые слова, скроллит в надежде отыскать крупицу смысла. Даже если не выйдет, времени на странице будет проведено немало.

Лет 5-10 назад еще можно было спрятать псевдотекст с ключами в подвал страницы, но с тех пор алгоритмы поумнели и перестали ценить то, чего никто не увидит. Найти содержимое футера сайта теперь можно только точным поиском по фразе ("в кавычках").

Так для чего все эти ухищрения? Цель махинаций с контентом прозаична: заработать на рекламе или перенаправить трафик на другой ресурс. Хорошая новость в том, что переадресовывать становится сложнее: боты Google выучили JavaScript и способны предвидеть замену URL. Поэтому теперь редирект стараются представить как добровольный выбор пользователя:

Ясно, что нажимать не стоит: лучше обойтись без «эксклюзивных».

Зачем морочиться с подменой адреса? Не проще ли иметь на сайте 2 варианта страницы: ботам показывать текст, который способен ранжироваться, а пришедших из Поиска людей встречать за столом казино

Проще, но о бесцеремонной маскировке контента станет известно, хотя бы благодаря возможности пожаловаться на недобросовестный сайт. Тогда уж ручные санкции Google неминуемы: фальсификатору придется забыть о позициях (или применить ответные санкции). С другой стороны, если клоакинг был использован только для внедрения ключевых фраз, посетитель вряд ли узнает об этом.

Update: На что способен BERT – новый алгоритм Google?

С запуском алгоритма BERT 21.10.19 Google стал лучше понимать фразы. Когда изменения вступят в силу на всех языках, не будет нужды по-особому выстраивать слова в запросе: «гаджет цвет купить недорого город». К тому же система обещает серьезнее относиться к отрицаниям, предлогам и прочим коротким словечкам.

И вот, наконец: 9 декабря 2019 обновленный BERT заговорил на русском.

Заключение (оптимистическое)

Машины, как и люди, не всегда справедливы. Но за каждую синюю ссылку Google отвечает репутацией, поэтому вполне искренне – как для корпорации – стремится выдать качественный результат. Со временем алгоритмы научатся отделять зерна от плевел, а пока не помешает им немного помочь: предоставить образцы контента для исследования .

Главное, чтобы материал сразу был проиндексирован, а оценен по достоинству может быть и потом. Шансов привлечь аудиторию прибавится, если страницы появятся в выдаче с расширенным сниппетом.

Если кто-то заметит ваш сайт в Поиске, заглянет и останется надолго, поисковик быстрей смекнет, что вы предлагаете что-то стоящее!